Synchronization und Kommunication in Musikalischen Ensembles (INSYNC)

| Projektnummer: | FWF P 24546 |

| Projektleiter: | Assoz.-Prof. MMag. Dr. Werner Goebl |

| Forschungsstätte: | Österreichisches Forschungsinstitut für Artificial Intelligence Wien |

| Kooperationspartner: | Institut für Musikalische Akustik – Wiener Klangstil (IWK) Universität für Musik und darstellende Kunst Wien |

| Bewilligungsdatum: | 07.05.2010 |

| Prjektbeginn: | 01.11.2012 |

| Projektende: | 30.09.2016 |

| Projekt-Webseite: | http://ofai.at/research/impml/projects/insync.html |

Kurzfassung

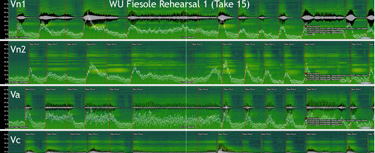

Zu den grundlegenden Eigenarten menschlichen Zusammenlebens gehört die Fähigkeit des Menschen, sich mit anderen Menschen zu koordinieren, mit ihnen zu kommunizieren und seine Gedanken und Handlungen aufeinander abzustimmen. Besonders faszinierend wird diese Fähigkeit im Falle von musikalischem Zusammenspiel. Ein Großteil der Musiken dieser Welt wird ja nicht von einer Person alleine aufgeführt, sondern von mehreren. Vom Vierhändigspiel zweier PianistInnen, über ein Streichquartett, eine Jazz-Combo, bishin zum Symphonieorchester mit Chor und Solisten reichen die unterschiedlichen Möglichkeiten, miteinander zu musizieren. Jede einzelne hat ihre eigene Dynamik im zwischenmenschlichen Zusammenspiel: von einer Demokratie kleiner Ensembles, in der einzelne Musiker zuweilen führen um dann wieder geführt zu werden, bis hin zu mehr "diktatorischen" Systemen, in denen sich Musiker dem Spiel oder den Gesten eines Einzelnen unterzuordnen haben (Solist versus Korrepetitor oder Dirigent versus Orchester). In diesem Projekt wird untersucht, wie Musiker ihr Spiel und ihre Bewegungen zeitlich und ausdruckstechnisch aufeinander abstimmen, welche mentalen und motorischen Mechanismen dabei zum Tragen kommen, über welche sensorischen Kanäle diese Kommunikation läuft, und wie die Lernprozesse und -strategien aussehen, die bei professionellen Ensembleproben ablaufen. Dabei sollen unterschiedliche Aufnahmesysteme zum Einsatz kommen (z.B. optische Motion-Capture-Systeme, Hybrid- Klavier), sowie computer-gestützte Methoden zur Datenauswertung und -modellierung. Die führende Vision ist es, die Synchronizations-Mechanismen und Lernprozesse so genau zu verstehen, dass sie in computationellen Modellen implementiert werden können. Solche Echtzeitsysteme werden dann zu interaktiver Experimentation herangezogen: eine Pianistin musiziert gemeinsam mit einem Computerprogramm, dessen Verhalten durch Änderung von Parametern wie Reaktivität, Solist/Begleiterverhalten, selektive Aufmerksamkeit auf einzelnen Ensemblemitglieder kontrolliert wird. Darüber hinaus werden die kommunikativen Gesten, die MusikerInnen untereinander einsetzen, in ihrer Kinematik untersucht, um in Folge Computern das Verstehen solch gestischer Kommunikation beizubringen. Ergebnisse dieser Forschung könnten nicht nur Einblick gewähren in die fundamentale Dynamik musikalischer Synchronisation, sondern etwa auch im musik-pädagogischen Bereich oder in der Unterhaltungsindustrie angewandt werden. Intelligente Begleitsysteme, die nicht subordonativ reagieren, sondern auch bisweilen führen und auch auf gestischen Input reagieren, neuartige Interaktionssystem für Computer Musik und disloziertes Musizieren, sowie Echtzeit-Visualisierungssysteme könnten reale Anwendungsszenarien dieser Forschung sein.

Publikationen

Hofmann, A., Wesolowski, B. C., & Goebl, W. (2017). The Tight-interlocked Rhythm Section: Production and Perception of Synchronisation in Jazz Trio Performance. Journal Of New Music Research, 46(4), 329–341. doi:10.1080/09298215.2017.1355394

Wesolowski, B. C., & Hofmann, A. (2016). There’s More to Groove than Bass in Electronic Dance Music: Why Some People Won’t Dance to Techno. PLoS ONE, 11(10:e0163938). doi:10.1371/journal.pone.0163938